¿Qué son los macrodatos o Big data y para qué sirven?

¿Qué se entiende por macrodatos?

Definición: las 3 V de los macrodatos

Volumen

Velocidad

Variedad

Fuentes de mac

rodatos: ¿de dónde proceden los datos?

Ejemplos para el uso de los macrodatos

Ejemplo 1: la industria del automóvil

Ejemplo 2: marketing

Ejemplo 3: sanidad

¿Por qué son importantes los macrodatos?

Cómo funcionan las tecnologías de macrodatos

Distribución en varios sistemas

Procesamiento paralelo

Gran escalabilidad

Análisis avanzados

Automatización

Los retos que plantean los macrodatos

El futuro que nos deparan los macrodatos

Los dispositivos digitales e Internet generan enormes cantidades de datos que las empresas pueden utilizar para adaptar mejor sus productos y servicios al mercado y a sus clientes. Por lo tanto, los macrodatos pueden contribuir de manera decisiva al éxito de una empresa. Pero ¿qué son realmente los macrodatos? ¿Y cómo se puede hacer un buen uso de ellos?

Este artículo explica de forma sencilla y comprensible qué son los macrodatos, de dónde proceden y para qué se utilizan. Aprenderás por qué tantas empresas recopilan datos con diligencia y qué programas son necesarios para ello. También te mostramos los retos que plantean y te ofrecemos una perspectiva del papel que desempeñarán los macrodatos en el futuro.

¿Qué se entiende por macrodatos?

Se trata de enormes cantidades de datos muy complejos y dinámicos que no pueden almacenarse ni evaluarse con los métodos convencionales de procesamiento de datos. Esto quiere decir que un solo ordenador no puede manejar las masas de datos, y los programas informáticos convencionales como Excel no pueden analizarlos. Para ello se necesitan equipamientos tecnológicos especiales. El término Big data también se utiliza a menudo para hacer referencia a este tipo de tecnología.

Definición: las 3 V de los macrodatos

Para definir los macrodatos, suele utilizarse el modelo de las 3 V. El informático Doug Laney describió las tres dimensiones esenciales de los macrodatos a principios de la década de 2000:

Volumen

Los conjuntos de datos comprenden a menudo varios millones de gigabytes. También se habla de petabytes (aprox. 1 millón de gigabytes) o exabytes (aprox. 1.000 millones de gigabytes). En la vida cotidiana, apenas nos encontramos con cantidades tan enormes de datos. Con esta comparación seguro que te queda más claro: un petabyte corresponde a unos 500.000 millones de páginas de texto. Como ya te imaginarás, un disco duro normal no tiene la capacidad de almacenar tantos datos. Debido a que suponen una enorme cantidad de datos, los macrodatos también se denominan datos masivos.

Velocidad

Los conjuntos de datos se crean a gran velocidad. Y como vuelven a perder valor rápidamente debido a su dinámica, también tienen que transmitirse y evaluarse a gran velocidad. Algunos dispositivos digitales pueden procesar flujos de datos dinámicos en tiempo real o casi real.

Variedad

Estos grandes conjuntos de datos que se mueven con rapidez contienen diferentes tipos de datos. Existen formatos estructurados, como las tablas ordinarias, y formatos semiestructurados y no estructurados, como fotos, vídeos o correos electrónicos. La diversidad de tipos de datos requiere sistemas especiales que permitan almacenarlos y analizarlos conjuntamente.

A lo largo de los años, se han ido añadiendo muchos otros términos con V al modelo de las 3 V, como, por ejemplo, la Veracidad (calidad o autenticidad de los datos) o el Valor (valor añadido de los datos). No obstante, según las distintas definiciones, las principales características de los Big data son siempre el volumen, la velocidad y la variedad.

Fuentes de mac

rodatos: ¿de dónde proceden los datos?

El volumen mundial de datos digitales no deja de crecer. Cada año se generan enormes cantidades de datos nuevos y en dimensiones cada vez más extremas: más rápidos, más complejos y en mayor volumen. Esto no es de extrañar en vista del avance de la digitalización. Un sinfín de dispositivos digitales, sistemas inteligentes y aplicaciones inundan el mercado. Miles de millones de personas utilizan Internet y diversos medios digitales. Cada vez más empresas y administraciones pasan por procesos de transformación digital. Y la infraestructura digital se amplía constantemente mediante tecnologías innovadoras. Esto da lugar a numerosas fuentes de datos, por ejemplo:

Teléfonos inteligentes

Relojes inteligentes

Dispositivos inteligentes para el hogar

Redes sociales

Motores de búsqueda

Servicios de streaming

Comercio electrónico

El Internet de las cosas o IoT es una gigantesca red de tecnologías y sistemas de software que se conectan entre sí a través de Internet y que intercambian datos.

Ejemplos para el uso de los macrodatos

En este mundo digitalizado en el que vivimos, se puede decir que los datos están prácticamente disponibles en cualquier momento y lugar. Algo que las empresas y los investigadores no han pasado por alto, sino más bien todo lo contrario. Las diferentes industrias, los departamentos y sectores sociales pueden obtener nuevas perspectivas gracias a los macrodatos. He aquí algunos ejemplos:

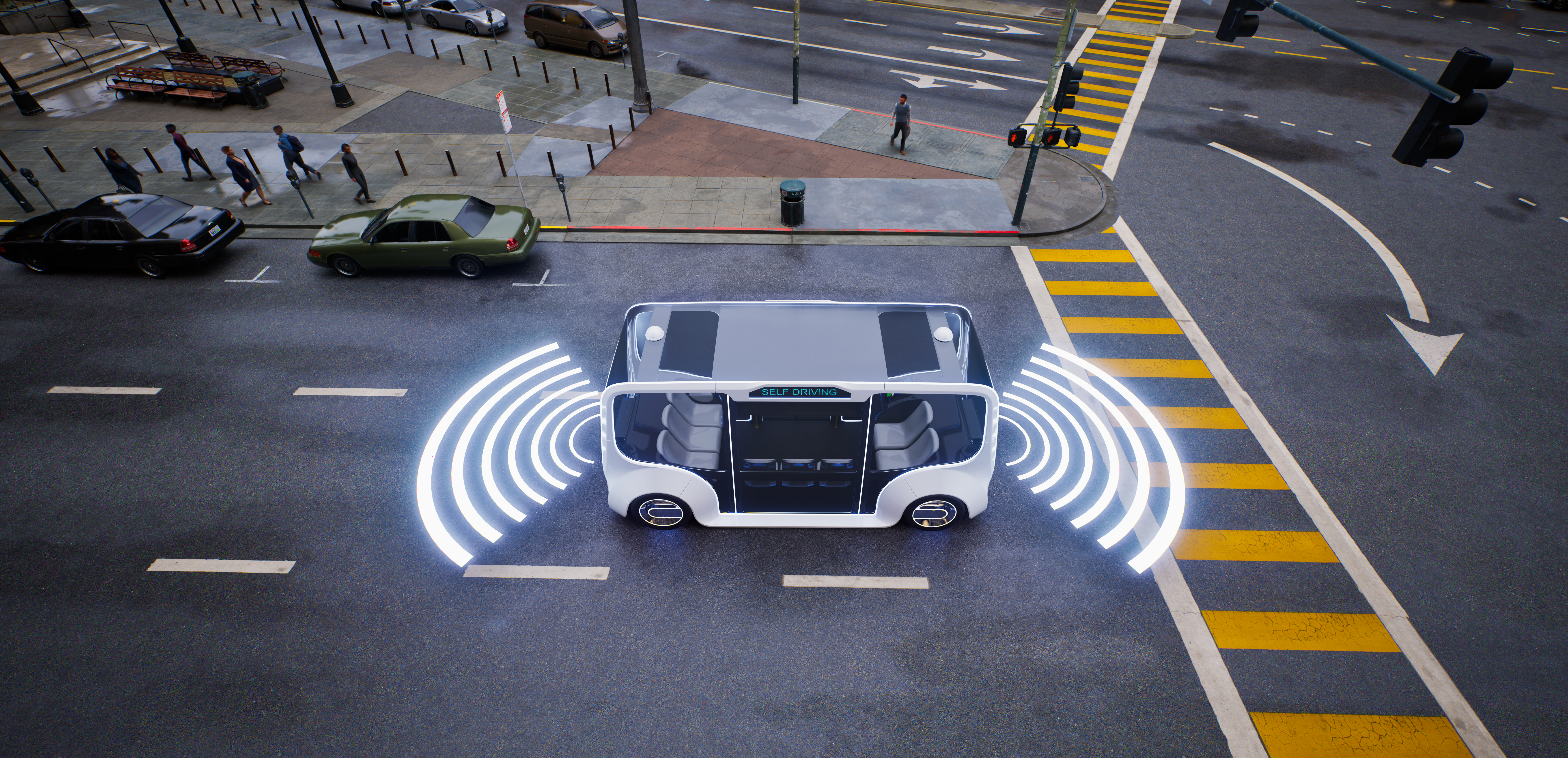

Ejemplo 1: la industria del automóvil

Un «combustible» importante para la conducción automatizada y autónoma son los datos, y no pocos. Cuanto más autónomo sea un vehículo para entrar en circulación, mejores deben ser los algoritmos de los sistemas de IA integrados. El marco de referencia son los datos de kilómetros de conducción en simulaciones, en lugares de prueba y, por último, también en el tráfico rodado real. De este modo, la inteligencia artificial puede poner a prueba una gran variedad de escenarios en el tráfico rodado. Esta escuela de conducción del automóvil basada en datos garantiza un alto nivel de seguridad para los ocupantes del vehículo.

Ejemplo 2: marketing

Los datos de los clientes enriquecen al sector del marketing. Piensa, por ejemplo, en tu marca favorita. ¿Qué información le estás dando a la empresa sobre ti? Tal vez compres en su tienda en línea. O sigas a la marca en las redes sociales e interactúes con sus publicaciones. Puede que incluso rellenes encuestas de clientes, escribas reseñas o tengas una tarjeta de fidelidad. Todas estas acciones generan datos: datos sobre tu perfil de compra, tu uso de los medios de comunicación, tus preferencias, tu fidelidad a las marcas, etc. La empresa puede utilizar estos datos para conocerte mejor como cliente y enviarte información personalizada a través de los canales que utiliza con más frecuencia.

Ejemplo 3: sanidad

En medicina y sanidad se generan grandes cantidades de datos de pacientes y de la población en general, por ejemplo, a través de las compañías de seguros médicos, las aplicaciones sanitarias o las consultas de búsqueda sobre síntomas. Utilizados con sensatez, estos datos pueden ayudar, por ejemplo, a mejorar la atención individual de los pacientes o a diseñar servicios preventivos eficaces.

¿Por qué son importantes los macrodatos?

«Los datos son el nuevo petróleo»: este dicho resume bastante bien la tendencia del Big data, porque los datos se consideran la materia prima del futuro. La transformación digital está poniendo patas arriba el mundo empresarial y laboral y los datos digitales se están convirtiendo en un recurso central. Las grandes corporaciones tecnológicas basan su éxito en enormes conjuntos de datos y cada vez son más las pequeñas y medianas empresas que también quieren explotar el potencial de los macrodatos.

Pero no se trata de recopilar tantos datos como sea posible, sino de utilizar eficazmente los datos existentes. Al procesarlos y evaluarlos, se pueden identificar tendencias, patrones y correlaciones. Esto proporciona valiosos conocimientos sobre los procesos, los productos, los mercados y las personas. Sobre esta base, las empresas pueden:

Gestionar mejor los procesos y los recursos (por ejemplo, ahorrar tiempo y costes)

Optimizar los productos o desarrollar otros nuevos en función de las tendencias del mercado

Tomar decisiones empresariales basadas en datos

Pero no solo las empresas pueden beneficiarse de los macrodatos. Los datos también pueden conducir a un mayor conocimiento y progreso en ámbitos públicos como la medicina, la educación o la administración.

Cómo funcionan las tecnologías de macrodatos

Los macrodatos no se traducen automáticamente en conocimiento y progreso. Primero, es necesario almacenar, gestionar y, sobre todo, evaluar los datos con eficacia. Esto requiere tecnologías y herramientas especiales. Las soluciones adecuadas para el uso de macrodatos funcionan según los siguientes principios:

Distribución en varios sistemas

Los datos no se almacenan y procesan en un único dispositivo, sino que se distribuyen a través de varios dispositivos conectados en red. Pueden ser ordenadores o servidores en un centro de datos. Una solución remota, por otra parte, es la computación en la nube. En ella, los datos se almacenan en línea y se puede acceder a ellos en cualquier momento y desde cualquier lugar con una conexión a Internet.

Procesamiento paralelo

Con volúmenes de datos en el rango de los peta y los exabytes, se tardaría mucho tiempo en procesar los datos uno por uno. Para acelerar la evaluación, tanto los datos como los pasos parciales del análisis de datos se distribuyen en varios ordenadores. De este modo, los datos pueden procesarse simultáneamente o en paralelo. Posteriormente, se fusionan los resultados parciales. Esto resulta mucho más rápido que un enfoque secuencial.

Gran escalabilidad

Dado que los flujos de datos son muy dinámicos, las capacidades de la infraestructura de macrodatos deben ajustarse constantemente. Esta es la única manera de interceptar eficazmente los picos o caídas en el flujo de datos. Y un sistema altamente escalable puede hacer precisamente eso: si es necesario, se añaden nuevos recursos informáticos para aumentar su tamaño y rendimiento. Los sistemas de almacenamiento altamente escalables para el uso de macrodatos incluyen los lagos de datos o las bases de datos NoSQL, también llamadas bases de datos no relacionales.

Análisis avanzados

Las distribuciones de frecuencias y las correlaciones no bastan para evaluar los macrodatos. Se requieren métodos analíticos más complejos, como la minería de datos o la inteligencia artificial. Pueden utilizarse en el ámbito de la inteligencia empresarial, donde se analizan sistemáticamente los datos de la empresa. Los métodos analíticos avanzados requieren, como su nombre indica, conocimientos avanzados. Los científicos de datos traen consigo estos conocimientos. Su tarea consiste en convertir los macrodatos en datos inteligentes y preparar la información obtenida de forma comprensible, por ejemplo, mediante visualizaciones.

Automatización

Para hacer frente a la creciente avalancha de datos, cada vez se demandan más soluciones automatizadas. Ya incluso hoy en día, no es posible gestionar y evaluar manualmente enormes cantidades de datos, y el volumen global de datos crece exponencialmente cada año. Las tecnologías que prometen reducir al máximo el factor humano en el análisis de datos son la inteligencia artificial, el aprendizaje automático y las redes neuronales.

Los retos que plantean los macrodatos

Cualquiera que trabaje con macrodatos debe estar siempre a la vanguardia de la tecnología. La infraestructura técnica se desarrolla constantemente y los métodos de procesamiento de datos cambian. Por ejemplo, hace tan solo unos años, el marco Apache Hadoop era el ecosistema común de macrodatos para almacenar y procesar grandes cantidades de datos. Pero, a día de hoy, existen ya Apache Spark y Apache Flink, que permiten un procesamiento de datos más rápido.

Otro reto que plantean los macrodatos es la calidad de los datos. Muchos conjuntos de datos tienen duplicados, lagunas o errores debido a su complejidad y a los rápidos cambios que experimentan. Antes de poder evaluar correctamente los datos, a menudo hay que limpiarlos, procesarlos y comprobarlos en un proceso que lleva mucho tiempo.

Un punto de crítica frecuente en el debate sobre los macrodatos es la protección de datos. Las empresas recopilan mucha información sobre sus clientes, y parte de ella, es de carácter privado. Los usuarios de servicios en línea, aplicaciones o dispositivos inteligentes a menudo desconocen qué datos se están utilizando, por quién y con qué fin. Hacer un seguimiento de los propios datos es un gran reto para todos ante la creciente avalancha diaria de información a través de los medios digitales e Internet.

El futuro que nos deparan los macrodatos

Los datos seguirán siendo un activo valioso en esta sociedad marcada por la información y el conocimiento. La cantidad de datos generados aumenta rápidamente cada año y el mercado de las tecnologías de macrodatos e IA no deja de crecer. Actualmente, están de moda las aplicaciones y soluciones de aprendizaje automático que pueden procesar datos en tiempo real.

Debido a su alto potencial para generar conocimiento y automatizar procesos, los datos y la analítica de macrodatos actúan como impulsores clave de la Industria 4.0. Temas como la protección de datos y la seguridad de la información siguen siendo prioritarios. Fenómenos como los deepfake o la discriminación por parte de la IA también se discuten cada vez más.

Por lo tanto, los macrodatos y la Inteligencia Artificial no solo deberían ser de interés para los expertos en datos y los desarrolladores de IA. Nuestro curso «Big data: entender cómo funciona el mundo de los datos» le proporcionará una comprensión básica más profunda.